Histoire

du micro-ordinateur

19 décembre 2003

Nous avons décrit les

circonstances de l’invention du microprocesseur chez Intel en 1971.

Un micro-ordinateur, c’est un ordinateur équipé d’un microprocesseur. Le

micro-ordinateur ne pouvait donc pas naître avant le microprocesseur. Mais il

ne suffisait pas que le micro-ordinateur naquît : il fallait aussi qu’il

rencontrât un terrain favorable au succès commercial. Ce terrain a été préparé

par les « hackers », ces pionniers qui ont rêvé le micro-ordinateur et la

dissémination de l’informatique longtemps avant qu’ils ne fussent possibles, et qui étaient ainsi prêts à tirer parti de

l’innovation technique dès que celle-ci se produirait.

I - Les origines

Les « hackers » des années 60 et 70

L'informatique était dans les

années 60 l'affaire de professionnels stylés par IBM. Ostensiblement

« sérieux », ils portaient costume, cravate noire et chemise blanche.

Les utilisateurs n'étaient pas autorisés à approcher la machine.

Mais les « hackers »

(que l’on a appelé aussi « hobbyists ») revendiquaient le droit

de comprendre comment la machine fonctionne, d'y accéder, de travailler en

temps réel et donc de modifier la façon dont on utilisait l'ordinateur. Avant

eux, l’ordinateur était une grosse machine sans écran, sans carte sonore,

sans traitement de texte, sans tableur, sans réseau etc. Ils ont inventé les

procédés qui ont permis d'introduire ces perfectionnements.

Un « good hack »,

c’est une astuce qui marche, un procédé qui permet de faire faire quelque

chose de nouveau par l’automate – peu importe d’ailleurs si l’on ne

sait pas exactement pourquoi ni comment cela fonctionne. La passion des hackers, c'était

de créer de « good hacks », non de les vendre ni de « faire du

business ». Ils copiaient sans vergogne les programmes, les modifiaient,

les communiquaient. L'« open source » (ou « logiciel ouvert »),

dont le programme source est fourni et modifiable à volonté, allait alors de

soi.

La première équipe de

hackers, la plus flamboyante, fut celle du MIT ; puis d'autres équipes de

passionnés se sont créées ailleurs : aux Bell Labs d’AT&T, à

l'université de Berkeley et, dans

les années 70, au Palo Alto Research Centre (PARC) de Xerox. Les hackers du MIT

estimaient avoir le droit et même le devoir d’accéder à la machine quelles

que soient les interdictions et réglementations, même s’il fallait pour cela

fabriquer de fausses clés pour pouvoir se faufiler de nuit dans un centre informatique.

Mais ils n’étaient pas des pirates, des briseurs de sécurité, des fabricants de

virus : le mot « hacker » n’a pris ce sens péjoratif que récemment.

Les hackers des années 60 et 70 étaient des pionniers .

Ils ont mis au point des

langages et des méthodes, inventé l'intelligence artificielle etc. Le système

d’exploitation Unix (1969), le langage C (1972) mis au point aux Bell Labs ont

été d’abord distribués gratuitement ou pour un paiement symbolique, ce qui

a permis de les perfectionner rapidement. La souris a été inventée par

Douglas Engelbart en 1968, les fenêtres et menus déroulants par Dan Ingals au

PARC de Xerox en 1974

Enfin les hackers ont cherché à mettre l'ordinateur à la disposition de tout

le monde, d'abord en disséminant des terminaux, puis en mettant au point le

micro-ordinateur.

Steven Levy a décrit les rêves

et les ambitions de ces passionnés qui travaillaient parfois trente heures d'affilée

et sacrifiaient leur santé et leur vie affective à l'exploration des

possibilités de l'ordinateur, au développement d’outils qui permettraient de

les concrétiser. Leur imprégnation par le langage informatique les coupait des

modes de communications naturels et les isolait des autres êtres humains. Ils

avaient une morale, « l'éthique des hackers ».

L'émergence du commerce des

logiciels au milieu des années 70 a mis un terme à cette époque qui se prolonge

cependant dans l’école du logiciel ouvert. La créativité des hackers a ouvert la voie d’une

nouvelle informatique.

« The

Hackers Ethic »

1)

L’accès aux ordinateurs – et à tout ce qui peut vous apprendre quelque

chose sur la façon dont le monde fonctionne –doit être illimité et total.

Respectez toujours le « Hands-On Imperative » !

« Hands-On

Imperative », cela veut dire que quand on rencontre un obstacle, il faut

« y mettre les mains » et résoudre le problème sans attendre que

l'on vous y invite ou que l’on vous y autorise .

2)

L’information doit être gratuite.

La

gratuité de l'information et des logiciels est supposée plus efficace, par

les synergies qu'elle permet, qu'une économie où les logiciels seraient

vendus sur le marché et protégés par des copyrights. La transition entre la

gratuité et le marché sera le « software flap » provoqué par

Bill Gates lorsqu'il publia en février 1976 sa « Open Letter to

Hobbyists » dans Computer Notes, « newsletter » des

utilisateurs de l’Altair (voir ci-dessous).

3)

Ne pas faire confiance à la hiérarchie, promouvoir la décentralisation.

Les

hackers étaient, bien avant d’autres, partisans de l'organisation

transverse qu'ils jugeaient seule efficace. Ils étaient par ailleurs

insensibles aux prestiges de la hiérarchie, comme le montre la règle

suivante :

4)

Juger les Hackers selon la qualité de leurs hacks et non selon des critères

farfelus comme le diplôme, l’âge, la race ou le grade.

Seule

compte la compétence, le niveau atteint dans la maîtrise de la machine : il

s'agit de contourner les obstacles que celle-ci oppose à ceux

qui veulent la plier à leurs besoins.

5)

Vous pouvez créer de l’art et de la beauté avec un ordinateur.

L'ordinateur

n'est pas seulement fait pour calculer, comme le suggère le mot « computer »,

ni pour mettre de l'ordre, comme suggère le mot « ordinateur » :

on doit pouvoir l'utiliser pour faire de la musique, dessiner, créer des

mondes imaginaires qui donneront aux rêves un prolongement (presque) aussi

vrai que le monde réel. C'est l'origine des mondes virtuels qui ont eu tant

d'importance lors de l'explosion du marché des jeux. Il est significatif

qu'une bonne part du progrès des ordinateurs en performance, convivialité et

ergonomie provienne de leur utilisation ludique. Il est intéressant de noter

que les « hackers de la troisième génération », qui ont

grandi dans les années 70, sont venus à l'informatique par la pratique des

jeux .

6)

Les ordinateurs peuvent améliorer votre vie.

Les

hackers n'ignorent pas les risques que comportent certains usages de

l'ordinateur (en particulier ses utilisations militaires les effraient), mais

ils affirment que des utilisations utiles, progressistes, constructives sont possibles.

Les hackers ont travaillé sur

ce qui était à leur époque la « couche critique » de

l’informatique, cette expression désignant l’ensemble des questions

qui se trouvent sur le front de taille de la discipline.

Il s'agissait dans les années

60 de mettre au point les langages qui permettraient de diversifier les utilisations de

l'ordinateur : la couche critique était alors celle du logiciel.

Dans les années 70 il s'est agi de mettre l'ordinateur dans les mains de chacun

en s'appuyant sur les nouveaux micro-processeurs : la couche critique fut

alors celle du matériel ; une fois traitée, il a été possible de

réaliser les développements qui ont conduit au micro-ordinateur en réseau

d'aujourd'hui, avec ses interfaces graphiques, son équipement multimédia et

l'Internet.

La couche critique est

aujourd’hui celle de l'utilisation collective, organisée, du

micro-ordinateur en réseau par les entreprises, la société et les

individus. L'utilisation individuelle pose des questions qui relèvent de la

psychologie ; l'utilisation collective pose des questions qui relèvent de la

sociologie et de l'organisation. Sociologie et psychologie constituent deux

couches, différentes mais solidaires, du même empilement. Les héritiers des

« hackers », des pionniers des années 60 et 70, sont ainsi

aujourd'hui les personnes qui travaillent sur le langage de l'entreprise,

l'organisation transverse, l'articulation du système d'information avec la

stratégie, la modélisation des processus, l’urbanisation des systèmes

d’information etc.

Reprenons le chemin qui a

conduit du premier micro-ordinateur aux réseaux de machines d’aujourd’hui.

Un précurseur : le Kenbak-1 (1971)

John V. Blankenbaker présente

le Kenbak-1 au printemps de 1971 ; cette machine, dotée d’une RAM de 256

octets, était vendue en kit au prix de 750 $. Comme le 4004 d’Intel n’était

pas encore commercialisé – il ne sera mis sur le marché qu’en novembre

1971 – l’unité centrale du Kenbak-1 comporte plusieurs composants MSI et

LSI : il ne s’agit donc pas d’un micro-ordinateur au sens exact du

terme, mais d’un ordinateur à circuits intégrés. Le Kenbak-1 avait pour but

d’aider l’apprentissage de la programmation. Après en avoir vendu 40

exemplaires, la Kenbak Corporation a été supprimée en 1973.

Le

premier micro-ordinateur : le Micral (1973)

En 1971 André Thi Truong, ingénieur

français d’origine vietnamienne, fonde la société R2E (Réalisations Études

Électroniques). En 1972 l’INRA (Institut national de la recherche

agronomique) commande à R2E un système informatique transportable. R2E conçoit

alors un ordinateur fondé sur le processeur 8 bits Intel 8008 .

Le Micral est créé en six mois. La machine a été conçue par André Thi

Truong, le logiciel par Philippe Kahn.

Gros comme l’unité centrale

d’un PC actuel, le Micral ne dispose ni d’écran ni de clavier. La saisie se

fait en binaire, en manipulant des interrupteurs. On peut lui connecter un lecteur de bandes

perforées. 500 Micrals sont produits la première année ; ils sont vendus

8 450 F pièce (1 750 $ de l’époque). En juin 1973 la revue américaine Byte

invente le mot « microcomputer » pour baptiser le Micral :

le micro-ordinateur est né.

Le Micral n’a pas

connu le succès commercial ; il a été utilisé essentiellement pour

automatiser des postes de péage des autoroutes .

Autres précurseurs

Le Scelbi (« Scientific,

Electronic and Biological ») de la Scelbi Consulting Company (Milford,

Connecticut) fut annoncé dans l’édition de mars 1974 de la revue QST.

Construit autour du microprocesseur 8008 d’Intel, le Scelbi avait 1 Ko de mémoire

programmable et il était vendu 565 $. 15 Ko de mémoire supplémentaire étaient

fournis pour 2760 $.

Le Mark-8, conçu par Jonathan

Titus, était lui aussi construit autour de l’Intel 8008. Il fut annoncé dans

le numéro de juillet 1974 de Radio Electronics.

L’Altair

8800 (1974)

Intel sortit le microprocesseur

8080 en juillet 1974. Il était vingt fois plus rapide que le 4004 et son

prix pouvait descendre jusqu’à 3 $ pour des commandes en quantité. Ce

microprocesseur sera au cœur de la conception de l’Altair, la machine qui a

enfin fait démarrer le marché du micro-ordinateur.

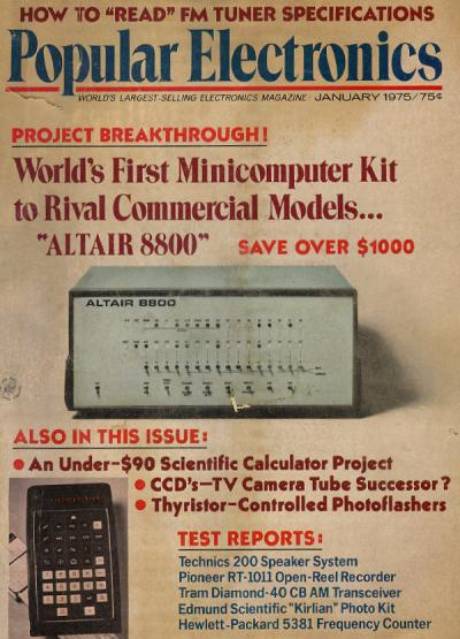

MITS (« Micro

Instrumentation Telemetry System »), petite entreprise d’Albuquerque au

Nouveau Mexique dirigée par Ed Roberts, a lancé l’Altair 8800 en décembre

1974. La photographie de ce micro-ordinateur paraît pour la première fois sur

la couverture du numéro de janvier 1975 de la revue Popular Electronics.

Dans les deux mois qui suivent des milliers de commandes arrivent à MITS.

L’Altair était commercialisé

en kit et il fallait beaucoup d’habileté pour le monter. L’unité de base

avait 256 octets de RAM et coûtait 395 $ : ainsi l’Altair était beaucoup

moins cher que le Micral. Comme il n’existait pas de logiciel, les

utilisateurs devaient écrire leurs propres programmes puis les saisir en

binaire en appuyant sur des boutons. Le résultat était affiché en binaire sur

des diodes.

On pouvait ajouter au système

un bus et des cartes d’extension. En quelques mois les cartes qui permettaient

d’accroître la mémoire ou de raccorder des terminaux furent disponibles. Le

télétype ASR-33 fournit un clavier, une imprimante et un support de stockage

sur bande de papier perforé. MITS commercialisa par la suite d’autres

versions améliorées (8800a, 8800b).

L’Altair et la naissance de Microsoft

Les origines de Microsoft sont intimement liées

à l’arrivée de l’Altair sur le marché. Suivons la chronologie telle

qu’elle est décrite par Microsoft .

Paul Allen (né en 1953, alors

employé par Honeywell) et Bill Gates (né le 28 octobre 1955, alors étudiant

en deuxième année à Harvard) étaient des amis passionnés par

l’informatique, des hackers. L’article de Popular Electronics les incita à programmer un interpréteur Basic pour

l'Altair : ce sera le premier langage de programmation pour

micro-ordinateur. Allen et Gates vendirent la licence de cet interpréteur à MITS le 1er février 1975.

Le 1er mars 1975,

Allen est embauché par MITS comme « Director of Software ». Le 7

avril 1975, Computer Notes, « newsletter » des utilisateurs

de l’Altair, annonce que l’interpréteur Basic est opérationnel .

Le 1er juillet 1975, une version 2.0 est publiée. Le 22 juillet

1975, Allen et Gates signent avec MITS un accord de licence. Le 29 novembre

1975, Gates utilise dans une lettre à Allen le nom « Micro-Soft » :

c’est la première mention écrite connue de ce nom.

Le 3 février 1976, Bill Gates

publie dans Computer Notes sa « Open Letter to Hobbyists »

(voir ci-dessous). Le 1er novembre 1976, Allen quitte MITS pour

rejoindre Microsoft à plein temps.

Le 26 novembre 1976, la marque

« Microsoft » est enregistrée auprès du bureau du secrétariat

d’état du Nouveau Mexique pour « nommer des programmes informatiques,

des systèmes d’exploitation et des services ». La déclaration

mentionne que le nom de Microsoft a été utilisé depuis le 12 novembre 1975.

La lettre ouverte de Bill Gates aux « Hobbyistes »

Dans sa lettre ouverte, Bill

Gates accuse de vol les « hobbyistes » qui ont piraté son interpréteur

Basic. Il leur reproche d’empêcher la production de bon logiciels et termine

par une phrase prophétique : « Rien ne me ferait plus plaisir que de

pouvoir embaucher dix programmeurs pour inonder le marché avec de bons logiciels ».

Cette lettre est importante

pour l’histoire de l’informatique : elle inaugure le modèle économique du

« logiciel compilé marchand vendu en boîte » qui succédera au modèle du

« programme source librement retouchable » des hackers. Bill Gates, né le 28

octobre 1955, avait vingt ans lors de sa publication.

Même si le modèle « open

source », revitalisé par l'Internet, est revenu en force vingt ans après

la publication de cet article, le modèle marchand a eu son utilité. Il était

sans doute le seul dans les années 70 qui pût permettre la production rapide

des logiciels nécessaires au succès du micro-ordinateur. Accessoirement, il

fut aussi à l'origine de la croissance de Microsoft et de la fortune de Bill

Gates (voir les statistiques sur l'évolution de

Microsoft).

|

February

3, 1976

An

Open Letter to Hobbyists

To

me, the most critical thing in the hobby market right now is the lack of

good software courses, books and software itself. Without good software

and an owner who understands programming, a hobby computer is wasted. Will

quality software be written for the hobby market?

Almost

a year ago, Paul Allen and myself, expecting the hobby market to expand,

hired Monte Davidoff and developed Altair BASIC. Though the initial work

took only two months, the three of us have spent most of the last year

documenting, improving and adding features to BASIC. Now we have 4K, 8K,

EXTENDED, ROM and DISK BASIC. The value of the computer time we have used

exceeds $40,000.

The

feedback we have gotten from the hundreds of people who say they are using

BASIC has all been positive. Two surprising things are apparent, however.

1) Most of these "users" never bought BASIC (less than 10% of

all Altair owners have bought BASIC), and 2) The amount of royalties we

have received from sales to hobbyists makes the time spent of Altair BASIC

worth less than $2 an hour.

Why

is this? As the majority of hobbyists must be aware, most of you steal

your software. Hardware must be paid for, but software is something to

share. Who cares if the people who worked on it get paid?

Is

this fair? One thing you don't do by steeling software is get back at MITS

for some problem you may have had. MITS doesn't make money selling

software. The royalty paid to us, the manual, the tape and the overhead

make it a break-even operation. One thing you do is prevent good software

from being written. Who can afford to do professional work for nothing?

What hobbyist can put 3-man years into programming, finding all bugs,

documenting his product and distribute for free? The fact is, no one

besides us has invested a lot of money in hobby software. We have written

6800 BASIC, and are writing 8080 APL and 6800 APL, but there is very

little incentive to make this software available to hobbyists. Most

directly, the thing you do is theft.

What

about the guy who re-sell Altair BASIC, aren't they making money on hobby

software? Yes, but those who have been reported to us may lose in the end.

They are the ones who give hobbyists a bad name, and should be kicked out

of any club meeting they show up at.

I

would appreciate letters from any one who wants to pay up, or has a

suggestion or comment. Just write me at 1180 Alvarado SE, #114,

Albuquerque, New Mexico, 87108. Nothing would please me more than being

able to hire ten programmers and deluge the hobby market with good

software.

Bill

Gates

General Partner,

Micro-Soft

|

L’apport du PARC de Xerox

Les dirigeants de Xerox,

entreprise qui avait construit sa fortune sur le marché des photocopieurs avec

la « xérographie », ont eu l’intuition du caractère porteur de

la microélectronique et de l’informatique. Xerox avait acheté Scientific

Data Systems en 1969 ;

elle décida alors de créer un centre de recherche.

Le « Palo Alto

Research Center » (PARC) de Xerox est créé en 1970. Il sera situé dans

la Silicon Valley, tout près de l’Université de Stanford, afin de pouvoir bénéficier

des apports de la recherche universitaire et de la force de travail des étudiants.

Quelques-uns des hackers les plus créatifs se rassemblent au PARC. Ils

vont apporter à l’informatique des innovations dont le micro-ordinateur

tirera parti.

L’histoire du PARC comporte

cependant un paradoxe : si Xerox a généreusement financé ce centre de recherche,

elle n'a pratiquement pas tiré parti de ses découvertes qui toutes seront

finalement commercialisées par d'autres entreprises .

Xerox a construit l'Alto, mais c'est IBM qui a lancé le PC en 1981. Xerox a

inventé l'interface graphique avec fenêtres, souris et menus déroulants, mais

c'est Apple qui a lancé le Macintosh et Microsoft qui a produit Windows. Xerox

a conçu le traitement de texte Wysiwyg ,

mais c'est Microsoft qui a produit Word. Xerox a mis au point le protocole de réseau

Ethernet, mais aujourd'hui le marché des réseaux locaux se partage entre Cisco

et 3Com. Xerox a inventé l'imprimante à laser, mais il s'est fait précéder

sur ce marché par IBM en 1975.

L’une des dates importantes

de l’histoire de l’informatique est la visite de Steve Jobs et d’une équipe

d’ingénieurs d’Apple

au PARC en décembre 1979. La démonstration à laquelle ils assisteront les

incitera à introduire l'interface graphique dans le Lisa (1983) et dans le Macintosh

(1984).

Les inventions du PARC dans

les années 70

1971 :

Alan Kay et son équipe mettent au point la première version de

Smalltalk, langage de programmation orienté objet qui influencera C++ et

Java ; Gary Starkweather met au point la première imprimante à laser.

1973 :

Chuck Thacker, Butler Lampson et Alan Kay mettent au point l'Alto,

ordinateur qui ne sera jamais commercialisé. Bob Metcalfe crée le

protocole de réseau local Ethernet.

1974 :

Dan Ingals invente un système qui offre l’interface avec

fenêtres superposées et menus déroulants. Charles Simonyi, Tim Mott et

Larry Tesler produisent le premier traitement de texte convivial.

1979 :

James Clark conçoit le microprocesseur graphique 3D qui fera par la suite

la fortune de Silicon Graphics.

30 septembre 1980 :

les spécifications du réseau Ethernet sont publiées. C’est la première

fois qu’une invention du PARC est commercialisée.

27

avril 1981 : Xerox lance la station de travail Star (16 000 $),

descendant commercial de l'Alto et des travaux du PARC. Mais le 24 août

1981 IBM lance le PC (2 000 $) qui rendra le Star obsolète.

1983 :

Après la démission forcée de Bob Taylor le 19 septembre 1983, plusieurs

des ingénieurs du PARC démissionnent. Le style de travail du PARC ne

sera plus le même.

Janvier

1984 : Apple lance le Macintosh, incarnation réussie de l'ordinateur

personnel conçu par le PARC. |

Pourquoi Xerox n'a-t-il pas

utilisé les travaux du PARC ? Il est tentant mais trop facile d'expliquer cela

par des comportements personnels, des conflits politiques dans l'entreprise ou

la stupidité de bureaucrates incapables de percevoir le potentiel d'une

innovation. Ces facteurs ont joué, mais ce ne sont pas les plus

importants. En fait il n'était pas facile de réussir dans le domaine des

ordinateurs personnels, comme l’ont bien montré les échecs rencontrés

ensuite par IBM et même par Apple ; s’il était en 1981 possible pour

Apple (40 personnes) de prendre de gros risques, c'était pratiquement

impossible pour Xerox (125 000 personnes).

Xerox s'était en effet spécialisée

sur le marché des photocopieurs, grosses machines que l'on installe dans les

secrétariats et que le fournisseur fait rémunérer à la copie. Le succès

de la xérographie avait mis Xerox en situation de monopole et l'avait

convaincue qu'il suffisait d'offrir de bons produits, mûrement conçus, pour

que les clients se jettent dessus. Cela ne la préparait pas au marché de

l'informatique personnelle où les acheteurs sont les directeurs informatiques,

où il n'est pas question de facturer à la consommation et où la concurrence

contraint à se battre pour chaque pourcentage de part de marché.

L'intérêt de Xerox pour

l'innovation était sincère, mais affaire de principe plus que de réalité ;

pour que Xerox puisse devenir un acteur sur ce marché, il aurait fallu que ce fût

une entreprise nouvelle, sans histoire, sans habitudes, sans organisation, libre

de se modifier comme le firent Apple et Microsoft. Mais ce n’était pas le

cas.

Toute grande entreprise, toute

organisation structurée par l’histoire répugne à changer et a donc tendance

à refuser l'innovation. Cela explique en partie les échecs de l'informatique

française : celle-ci a été poussée par l'administration française que

l'on peut considérer comme la plus grande entreprise du monde et qui, comme

toute grande entreprise, est corsetée par son histoire. Pour

concevoir le PC, IBM a dû créer en son sein une organisation indépendante que

le président a protégée contre le reste de l'entreprise et cela n'a pas

encore suffi : la culture d'entreprise ayant rejeté la greffe, IBM n'a pas

pu profiter du PC pour dominer le marché de la micro-informatique. Ce sont

Intel et Microsoft, structures minuscules en 1981, qui ont raflé la mise.

IBM et le PC

Voici les dates des principaux

événements qui ont marqué la suite de l'histoire du micro-ordinateur :

1982 : Compaq commercialise le premier

micro-ordinateur portable (il pèse 15 kg !).

1983 : Apple lance le Lisa,

premier ordinateur ayant une interface graphique (menus déroulants, fenêtres,

corbeille etc.) : le Lisa a été inspiré par les travaux du PARC (cf.

ci-dessus).

La norme IEEE 802.3 pour les réseaux locaux

Ethernet est publiée : elle concrétise les spécifications produites par

le PARC en 1980. C’est le début de la généralisation des réseaux locaux

dans les entreprises.

1984 : Lotus sort le tableur

Lotus 1-2-3 qui incitera les entreprises à acheter des PC.

Apple commercialise

le Macintosh, qui apparaîtra comme le grand concurrent du PC : les

utilisateurs se partagent entre partisans de l’une ou l’autre des deux

machines.

1985 : IBM lance le PC AT qui

a un grand succès.

IBM annonce en octobre le réseau Token Ring, qui concurrencera Ethernet dans les entreprises industrielles (voir

protocoles

d'accès aux réseaux de PC).

Intel lance le même mois le processeur 80386 à 16 MHz qui

améliore

de façon significative la puissance du PC. Microsoft livre en novembre Windows

1.0 qui apporte l’interface graphique aux utilisateurs de PC.

1986 : les bases de données

sur PC se développent avec dBASE d’Ashton et Tate.

Microsoft lance le tableur

Excel (d’abord connu sous le nom de Multiplan).

DEC connaît sa meilleure année,

mais ce sont les derniers feux du mini-ordinateur, dont le marché est coincé

entre la gamme des mainframes et le micro-ordinateur.

Compaq lance le marché

des clones PC en produisant le premier PC 386.

L’utilisation de la messagerie

électronique se développe aux Etats-Unis : MCI et Compuserve offrent un

lien entre leurs messageries respectives.

1987 : les PC 386 détrônent

les PC AT.

IBM lance la série PS/2 et le système d’exploitation OS/2.

Apple lance le Mac II.

Le 12

juillet 1987, Robert Solow formule dans la New York Review of Books

son célèbre paradoxe : « You can see the computer age everywhere but in

the productivity statistics. »

1988 : Unix gagne en notoriété et érode

la confiance dans les mini-ordinateurs et les mainframes.

Apple poursuit Microsoft et HP

en justice à propos de l’interface PC.

Compaq

prend la tête d’un consortium de fournisseurs connu comme " gang

des neuf ", et crée le standard EISA pour contrer le Micro Channel du

PS/2 d’IBM. Quelques semaines après l’annonce de l’EISA, IBM ressuscite

son bus AT avec le modèle PS/2 30-286. Il révèle aussi son offre de mini

AS/400.

1989 : Ethernet 10BaseT démarre.

C’est l’année des réseaux locaux de PC ; les hubs et adaptateurs de SynOptics et 3Com

ont un grand succès. Cela prépare la voie des applications client / serveur des années 90.

En avril Intel annonce le

processeur 486.

OfficeVision d’IBM, sa

première suite d’applications Systems Application Architecture.

Lotus

1-2-3 Version 3.0.

Portable Macintosh d’Apple.

1990 : C’est l’année des routeurs

et des WAN ("Wide Area Network") interconnectant les réseaux locaux de l’entreprise.

Microsoft lance Windows 3.0. En

septembre, IBM et Microsoft redéfinissent leur partenariat : IBM prend la

responsabilité d’OS/1.x et 2.x, et Microsoft de l’OS/2 portable, DOS et

Windows.

Motorola lance le processeur 68040,

Apple lance les Macs bas de gamme :

Classic, LC et IIsi.

1991: Windows est en position de

monopole, OS/2 disparaît de la scène.

Naissance

du World Wide Web : Tim Berners-Lee, au CERN de Genève ("Conseil Européen

pour la Recherche Nucléaire"), monte le premier serveur Web.

Les dépenses

des entreprises en informatique dépassent pour la première fois les dépenses en équipement

industriel, agricole et en construction.

Apple lance sa première génération

de Powerbooks.

1992 : C’est l’année des

applications sur réseau local de PC et du groupware avec Lotus Notes.

L’outsourcing émerge avec le gros contrat passé

par Kodak.

IBM et Microsoft mettent fin à

leur accord de coopération.

Pour la première fois, les comptes annuels d’IBM

font apparaître une perte de 564 millions de $.

Le départ de son président Ken Olsen marque

le début d’une ère nouvelle pour Digital.

Intel annonce son " clock

doubler " et lance le processeur 486DX2.

IBM annonce le premier de ses

notebooks : le ThinkPad.

1993 : Début du déploiement du

Pentium.

Les pertes d’IBM sont les

pires de son histoire : 4,97 milliards de $ pour un chiffre d’affaires de

64,5 milliards. Lou Gerstner remplace John Akers à la tête d’IBM :

c’est le premier " outsider " qui prenne le poste de CEO.

Apple perd son procès contre Microsoft et HP.

Intel lance le processeur 60 MHz

Pentium, Apple sort le Newton, Novell annonce NetWare 4.0, Lotus Notes 3.0 démarre,

et Microsoft lance Windows NT.

1994 : L’architecture client /

serveur prend pied sur le marché.

L’erreur de calcul révélée

sur la puce Pentium suscite un drame de relations publiques pour Intel, qui

y met un terme en remplaçant toutes les puces.

Microsoft annonce que Windows 95 ne serait pas livré avant août 1995, ce qui

mécontente beaucoup d’utilisateurs contraints à revoir leurs plans de migration vers le 32

bits.

La frénésie des fusions et acquisitions continue : Novell achète

WordPerfect pour 1,14 milliard de $, Aldus et Adobe fusionnent pour 525 millions

de $.

Apple entre sur le marché de la vente en ligne avec eWorld, et Netscape,

le chéri de Wall Street, fait ses débuts.

1995 : Les Notebooks deviennent une

alternative au desktop avec les portables Pentium. Il en résulte un développement

du télétravail.

IBM fait une offre de 3,5

milliards de $ pour acheter Lotus.

En août, Microsoft livre Windows 95 et Intel

lance le Pentium Pro à 150-200 MHz.

Compuserve, AOL et Prodigy commencent à

offrir des accès au Web, et Netscape lance la troisième plus importante

augmentation de capital sur le Nasdaq.

1996 : Windows 95 confirme son emprise sur

le PC. Windows NT gagne du terrain contre NetWare comme plate-forme pour serveur.

Les

Network Computers se concrétisent par de

vrais produits. Les Intranet d’entreprise deviennent une réalité.

Java gagne en notoriété. Les entreprises commencent à développer des

sites Web. Microsoft adopte finalement le Web.

1997 : C’est l’année de l’Intranet.

Le commerce électronique démarre.

La navigation sur le Web devient facile avec des browsers et des outils de

recherche améliorés. La puissance de traitement s’accroît lorsque Intel

annonce le Pentium 200 MHz avec la technologie MMX.

1998 : La

perspective de l’an 2000 effraie tout le

monde. Le manque de personnel en informatique devient aigu. L’outsourcing et

les services s’épanouissent.

Le grand thème est le commerce

sur l’Internet. Plusieurs événements importants non reliés au Web se

produisent : achat de Digital par Compaq, durcissement de la bataille entre

Microsoft et le ministère de la justice.

III - Histoire du PC : quelques technologies

importantes

CD-ROM

Les CD-Rom ont été

initialement conçus pour porter 74 minutes de son de haute qualité.

Transformés en supports de donnée de grande taille (650 millions d'octets),

ils épargnent aux utilisateurs les heures de travail qu'ils devaient consacrer

à

charger les applications disquette après disquette.

Les CD-ROM ont pratiquement

remplacé les disquettes, d'autant plus qu'il est possible de graver des CD. Cependant le CD-ROM

est concurrencé par les DVD-ROM et par les disques optiques capables

de contenir 4,7 milliards d'octets de données.

Cryptage

Sans les algorithmes de

cryptage, le commerce électronique n’aurait pas pu

se développer sur l’Internet : le cryptage est crucial pour identifier les

parties impliquées dans une transaction et sécuriser les transactions.

PGP ("Pretty Good Privacy"

), créé par Philip

Zimmermann, a suscité une accélération avec son architecture ouverte et ses techniques mathématiques robustes. Les autres leaders dans ce

domaine sont RSA Data Security, qui teste les limites des techniques de

cryptage, et Certicom, avec des innovations comme la courbe de protection

elliptique (économe en largeur de bande) qui fait partie de l’offre PalmNet de

3Com.

Groupware

Les racines du

groupware

se trouvent dans les systèmes de messagerie "store and forward "

des années 60 et 70 (à distinguer du "store and retrieve") et de conférence sur mainframe et mini, particulièrement dans les

universités et la recherche.

Les années 80 et 90 ont été celles du groupware. La mise en réseau des PC et la normalisation des

protocoles

répandent la communication dans l’entreprise et entre entreprises. cc:Mail de

Lotus et MHS ("Message Handling Service"

) de Novell aident à disséminer la messagerie alors que Lotus

Notes fournit des outils de programmation personnalisée et le lien avec les

applications externes.

Les années 90 et 2000 sont

celles du temps réel : le groupware a intégré les communications

synchrones (conversation, visioconférence, partage d’applications), supprimé

les barrières de temps et d’espace et permis des changements dans le travail

et la vie quotidienne. Les fonctionnalités du groupware se retrouvent sur

l'Intranet.

Jeu de commandes Hayes

Plus de 125 millions de modems Hayes sont installés

en Amérique du Nord. Même si l'entreprise Hayes a fermé en février

1999, les administrateurs de réseaux utiliseront pendant des années encore

" ATDT " (" attention, dial, tone ")

dans les scripts de dial-up.

Les réseaux locaux de PC et Ethernet

Plus que tout autre produit,

NetWare 2.11, Ethernet

10BaseT et 10Base2 ont apporté aux entreprises le partage des données et de la

puissance de traitement. NetWare a transformé le micro-ordinateur en une

machine analogue à un mainframe, et Ethernet permit de relier les ordinateurs

entre eux.

Sans la synergie entre ces

technologies, l’explosion de l’Internet n’aurait pas pu se produire car le

réseau d’ordinateurs serait resté coûteux. Elles sont évolutives :

Ethernet devient sans cesse plus rapide et s’étend aux nouveaux médias, les

LAN s’interconnectent de plus en plus.

Macintosh

En 1984, Apple a lancé le Macintosh

et transformé pour toujours les ordinateurs en introduisant trois

avancées technologiques (déjà utilisées dans la ligne de

produits Lisa) : interface graphique ; souris ; disquettes 3.5

pouces à haute capacité et très solides.

La conception du Mac doit

beaucoup aux idées du centre de recherche de Xerox à Palo Alto, mais Apple les

a retravaillées pour les rendre utilisables par un ordinateur produit en masse.

En refusant d’adapter le

MacOS à d’autres processeurs que la famille 68000 ou d’en vendre la licence

à d’autres entreprises, Apple a contraint les fabricants de clones à

chercher un autre système d’exploitation. Microsoft s’est engouffré dans la brèche

et, comme Apple perdait son temps à explorer trop de sentiers différents,

Windows a fini par devenir le système d’exploitation préféré des

entreprises et utilisateurs finals.

Toutefois, la migration d’Apple

vers la puissante puce du Power-PC sur RISC d’IBM, puis la sortie de la ligne

de produits iMac, ont maintenu Apple à flot.

Logiciel libre

Frustrée par les logiciels en

boîtes chers qui ne tenaient pas les promesses annoncées, la communauté des

informaticiens commença dans le milieu des années 90 à expérimenter le modèle

du " logiciel libre " qui permet à l’utilisateur d’accéder

aux parties intimes du système. Microsoft essayait de définir sa stratégie

sur le Web et Solaris était trop cher : les entreprises commencèrent à

utiliser des serveurs Web Apache sous Linux.

Le logiciel libre est le modèle de développement le plus efficace car il

permet aux exploitants de travailler comme une communauté de développeurs

utilisant une machine qu’ils contrôlent.

RAD

Au début, la RAD ("Rapid Application Development"

) n’a

fait que resserrer le processus d’" édition – compilation – débogage "

qui fut longtemps l’essentiel de la programmation. Dans le milieu des années

80, des produits comme Turbo Pascal de Borland ont accéléré le développement

d’applications pour PC DOS.

Visual Basic de Microsoft, lancé

en 1991, a défini le standard auquel tout nouvel outil doit se conformer (au

moins pour la commodité du développeur, si ce n’est en performance ou

robustesse des applications). Avec la diffusion de composants logiciels divers,

Visual Basic a accéléré une transition que des langages plus élégants

avaient seulement promis, pavant la voie aux classes Java réutilisables.

RISC

La technologie RISC ("Reduced Instruction Set Computer"

)

introduite par IBM sur les PC RT en 1986 a permis aux puces d’atteindre les

sommets de la performance informatique. Elle était conçue pour faire plus vite

les opérations habituelles et faciliter l’utilisation du microprocesseur. Mais ceux qui proposaient le RISC ont

sous-estimé la progression de l’architecture X.86 d’Intel, ainsi que sa

base installé en logiciels, outils et compétences.

Alpha de DEC, SPARC de Sun et

PowerPC de Motorola ont tenté de prendre l’avantage sur Intel au plan de la vitesse de traitement, puis Intel introduisit les techniques RISC dans le cœur

de sa ligne X86. Les puces Pentium, Advanced Micro Devices et autres appliquent

les principes RISC à l’optimisation interne tout en restant compatibles avec

les versions anciennes. Les utilisateurs y ont gagné.

SCSI

Au début des années 80, la

plupart des gens ne se souciaient pas de l’interopérabilité entre disques

durs. Mais Al Shugart a compris qu’il fallait un accès standard aux périphériques

si l’on voulait que le PC soit largement accepté par le marché.

En 1986, le SCSI ("Small Computer System Interface") offrit un

accès octet par octet aux données, ainsi qu’un adressage logique, supprimant

le besoin d’un accès en série lourd et inefficace. Lorsque le " Common Command " fut ajouté

un an après au SCSI il devint la base du langage de communication avec les périphériques,

pavant la voie à d’importantes innovations comme RAID ("Redundant Array of Independent Disks"

).

VGA

On avait déjà fait de la

couleur sur PC, mais l’inclusion du VGA ("Video Graphics Array") dans la ligne PS/2 par IBM

en 1987 fut un événement important. Le PC passait de 16 à 256 couleurs avec une

résolution de 320 pixels par 200. On pouvait aussi faire du 16 couleurs avec

une résolution de 640 pixels par 480. Cela favorisa le lancement des GUI ("Graphical User Interface"),

de l’édition et des jeux d’arcade sur PC. Même aujourd’hui, VGA est la

base de tout adaptateur vidéo sur le marché.

Le Web

Quand Tim Berners-Lee appliqua pour

la première fois l’hypertexte à l’Internet et forgea le terme " World Wide Web "

en 1990, il cherchait à créer une collaboration facile dans

les projets. En fait il a transformé l’Internet universitaire en un média de

masse.

Dans les neuf années qui

suivirent le premier browser et le premier serveur au CERN, le Web a acquis

l’ubiquité. L’information et la publication furent ses premiers points

forts, renforcés à la fin de 1993 par Mosaic et son utilisation graphique.

Enfin le milieu des affaires

perçoit vers 1996 le potentiel du Web et cherche à en tirer parti.

L’accroissement de la sécurité a réduit les réticences des clients envers

l’achat sur le réseau, tandis que des techniques comme XML facilitent

l’utilisation du Web pour les affaires.

Windows

Windows est un exemple de la méthode

pragmatique qui a permis le succès de Microsoft. D’abord pale imitation de

l’interface graphique du Macintosh, Windows était plein de bogues et handicapé

par le DOS sous-jacent. Toutefois Microsoft a montré que la compatibilité

ascendante, l’attention à des besoins peu intellectuels mais tirés par la

productivité, le support aux développeurs et l’OEM ("Original Equipment Manufacturer") sont plus importants

pour le succès d’un système d’exploitation que ses qualités purement

techniques.

Il en résulta l’adoption

massive de Windows sur les PC. Microsoft appliqua en 1993 la même formule pour

faire adopter Windows NT par les serveurs et stations de travail, ce qui a mis Novell

et Unix sur la défensive.

IV

- Histoire

du PC : quelques paris gagnés

Des projets a priori risqués

ont réussi :

Federal Express

En 1984, FedEx a lancé " Supertracker ",

fondé sur le " tracking " des paquets qu’il transporte Ce

système permettait aux coursiers sur le terrain d’utiliser des outils

communicants manuels et un réseau radio numérique pour saisir le statut et la

position des paquets (40 000 outils aujourd’hui, 6 millions

d’enregistrements quotidiens). Les clients peuvent connaître

par appel téléphonique la localisation de leurs paquets et la date de

livraison attendue. FedEx a gagné ainsi des parts de marché contre UPS.

Groupware

En 1989, les responsables du

système d’information de Price Waterhouse ont fait un choix audacieux :

ils ont supprimé la messagerie électronique qu’ils venaient d’installer

sur 10 000 postes et l’ont remplacée par Lotus Notes, produit nouveau que

personne ne comprenait et qu’ils déployaient sous OS/2. Price Waterhouse a ainsi été

la première grande entreprise à déployer Lotus Notes au niveau mondial. Cela

lui a permis de gérer ses projets globalement.

Le groupware a décollé,

notamment dans les entreprises de service. Coopers & Lybrand – qui a

fusionné avec Price Waterhouse en 1998 – a installé Notes en 1993, ce qui a

facilité la fusion des deux entreprises.

Interface graphique

En 1990, au milieu d’une

grave crise du transport aérien, United Airlines a jugé rentable de remplacer

ses terminaux " bêtes " par des PC dotés d’une interface

graphique. Jugeant Windows trop instable,

United a développé sa propre interface graphique. Le système, installé sur

des PC 80206, a permis de réduire le délai de traitement d’une réservation

de 10 %, la durée de la formation de 25 %, et d’économiser ainsi 9 millions de $ dès

la première année.

Datawarehouse

Dans le milieu des années 80

Wal-Mart voulait s’étendre au delà du Middle West. Mais comment gérer

plusieurs magasins en tenant compte des particularités de chaque marché local ?

Les managers de Wal-Mart eurent l’idée de collecter les données sur les

ventes et de les utiliser pour répondre rapidement à des changements de la

tendance de la demande.

Il en résulta un des plus

grands succès du datawarehouse. Le système grimpa rapidement à 700 milliards

d'octets. Il

permit au détaillant de partager l’information sur la demande avec ses

fournisseurs et de leur faire gérer ses stocks. Wal-Mart surpassa ainsi Sears

et Roebuck. Son datawarehouse, exploité sur

du matériel NCR Teradata, a cru jusqu’à 24 Teraoctets (24 000 milliards

d'octets).

Commerce électronique

En 1995, Barnes & Noble et

Crown Books développaient leurs réseaux de librairies concurrents. Jeffrey

Bezos, informaticien chez Bankers Trust à Chicago, se lança sur l’Internet

pour créer Amazon.com, première réussite du commerce électronique.

Amazon a démontré que l’on

peut faire du commerce électronique malgré les inquiétudes concernant la sécurité

sur le réseau. Elle offre plusieurs millions de titres de livres en ligne, des CD,

des livres audio, des DVD et des jeux pour ordinateur.

Par ailleurs Dell a prouvé

qu’il est rentable d’intégrer le commerce électronique avec le traitement

d’une chaîne d’approvisionnement. Lancé au début de 1997, le site de Dell

donne aux clients des dates de livraison exactes en contrôlant les stocks de pièces

détachées lors de la commande. Dell partage les informations sur la demande

avec ses fournisseurs en temps réel, ce qui permet de réduire les coûts

d’immobilisation et d’améliorer le service au client.

Le Wysiwyg (« What You See Is What You Get ») est le principe le plus

important de l'interface graphique : chaque manipulation de l'image sur l'écran

entraîne une modification prévisible de l'état du système. Les éléments

de cette métaphore sont les fenêtres (Windows), menus, icônes, boutons,

onglets ainsi que le pointeur. Les fenêtres permettent la représentation

simultanée de plusieurs activités sur l'écran. Les menus permettent de

choisir les prochaines actions. Les icônes, boutons, onglets etc.

attribuent une forme concrète aux objets informatiques. L'outil de

pointage, souris ou track-ball, sélectionne fenêtres, menus, icônes etc.

La

coopération avec Microsoft fit apparaître quelques défauts chez IBM:

« Les gens de Microsoft se plaignaient de la méthode de programmation

d’IBM […] IBM mesurait le nombre de lignes produites par chaque

programmeur, ce qui encourageait la production de code inefficace. Les

gestionnaires d’IBM se plaignaient parce que, selon leur système de

mesure, Microsoft ne faisait pas sa part du travail. Ils disaient que si

l’on comptait le nombre de lignes, Microsoft faisait en fait un travail négatif, ce qui signifiait que Microsoft aurait dû payer IBM parce

qu’il condensait le code »

Cette

façon de mesurer la production pousse à écrire de programmes lourds. IBM

la jugeait efficace parce qu'elle induisait une forte utilisation des

machines et incitait à terme les clients à acheter de nouveaux ordinateurs

plus puissants. (Paul

Carroll, Big

Blues, The Unmaking of IBM,

Crown Publishers 1994, p. 101.)

|